Во исто време, вештачката интелигенција и нејзините практични примени, како што се чет-ботови за генерирање текст или моделите на дифузија за создавање слики, станаа достапни за сите, надвор од вообичаената група на истражувачи во приватни компании и водечки универзитети. Со сите нејзини позитивни аспекти, генеративната вештачка интелигенција е усвоена од страна на оние што се занимаваат со дезинформации за да го забрзаат своето дејствување.

Иако вештачката интелигенција (сè уште) не ги надминала традиционалните методи за создавање и ширење дезинформации, во овој текст ќе ги разгледаме реалните примени на вештачката интелигенција во информациските операции на Кремљ во текстуална, аудио и видео содржина, како и автоматизација, како и автоматизацијата, за да ги покажеме областите каде што овие алатки веќе ги користи агресорската држава.

Видео

Употребата на вештачки изменети видеа започна речиси веднаш по инвазијата, кога на 16 март 2022 година, руски извори хакираа веб-страница на украински медиум и поставија лошо изработена лажна снимка за украинскиот претседател Володимир Зеленски. Во видеото, лажна верзија на Зеленски тврди дека поднел оставка, побегнал од Киев и ги повикува вооружените сили на Украина да се предадат за да си го спасат животот. Екстремно нискиот квалитет на видеото јасно укажуваше дека станува збор за длабински лажни видеа (deepfake), каде што лицето на претседателот е наметнато врз неговото тело. Затоа, дури и проруските извори на Телеграм почнаа да го нарекуваат видеото лажно, додека се фалеа дека сепак „успеало да натера некои украински војници да се предадат“.

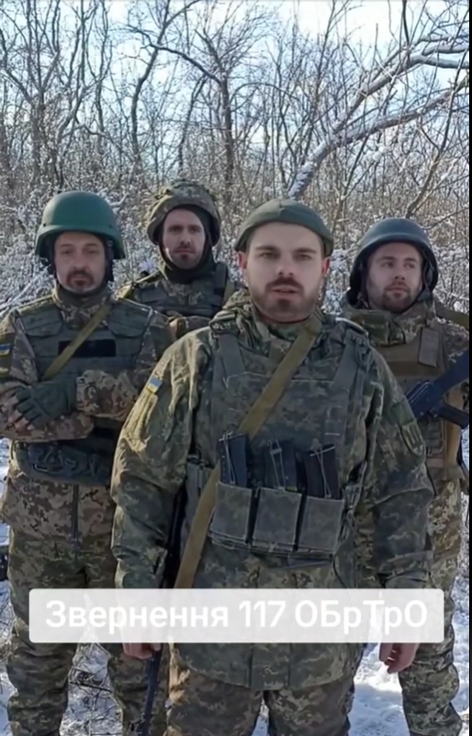

Сепак, технологијата напредува и го подобрува квалитетот на видео фалсификатите. На пример, руските канали на Телеграм дистрибуираа видео на Тик-ток кое наводно прикажува војници од 117-тата територијална одбранбена бригада [Одделна територијална одбранбена бригада – заб.] како го повикуваат украинскиот генерал Валериј Залужни да ја отстрани актуелната власт. Бригадата подоцна ја демантираше автентичноста на видеото и објави соопштение дека лицата прикажани во видеото никогаш не биле дел од бригадата. Центарот за спротивставување на дезинформации претпостави дека видеото е создадено со технологија за длабински лажни видеа.

Посебен пример на користење на видео и аудио манипулација истовремено е синхронизирање на усните – метод каде што гласот на некое лице се клонира, а се менува само долниот дел од лицето за да се усогласи со зборовите кои се внесуваат во устата на говорникот.

Еден впечатлив пример за таква кампања е лажниот говор на Алексеј Данилов (Олексія Данилов), поранешен секретар на Советот за национална безбедност и одбрана. Голем број на руски пропагандисти објавија интервју со Данилов во кое наводно тој презема одговорност за терористичкиот напад во Градското собрание Крокус и најавува уште повеќе „забава“ за Русите. Сепак, Данилов не дал интервју за телемаратонот на денот на нападот и никогаш не ги изговорил тие зборови. Неговите изрази на лицето не се совпаѓаат со зборовите, а фабрикуваното видео е составено од две различни видеа – интервјуа на Кирил Буданов и Данилов дадени за различни медиуми.

Во друг случај, се појави видео од уапсен маж кој признава дека украинската разузнавачка служба му наредила да го убие американскиот ултрадесничарски медиумски лик Тaкер Карлсон за време на неговата посета на Москва во февруари 2024 година. Подоцна, во извештај на „Полиграф“ (Polygraf) се утврди дека лицето чиј глас се слуша во видеото покажува знаци на „дигитална манипулација“. Дополнително, неговите изрази на лицето не се совпаѓаат со изговорените зборови.

Иако употребата на видео е доста честа, технологијата сè уште не е совршена и ваквите дезинформациски пораки брзо се разобличуваат од страна на проверувачите на факти.

Аудио

Употребата на аудио станува сè пораспространета и функционира на неколку нивоа. Прво, се клонира глас за да се генерираат зборовите што некое лице ги изговара. Оваа технологија има позитивна примена, како што е генерирање гласови на починати актери за нови улоги и камео појавувања. Како во случајот со украинскиот стартап „Респичер“ (Respeecher), кој го „оживеа“ гласот на актерот Џејмс Џонс, кој го позајми гласот на Дарт Вејдер во „Војна на ѕвездите“, за нова улога.

Сепак, агресорската држава користи слични технологии за свои цели. На пример, еднаш беше искористена лажна аудио снимка на гувернерот на Тексас, Грег Абот, земена од интервју на „Фокс њуз“ (Fox News) за имиграциската политика на САД. Руски извори објавија изменета верзија од интервјуто на Телеграм, со променет глас на гувернерот, додека видеото беше изменето со вметнување дополнителни снимки, познати како „b-roll“, кога говорникот не е во кадар. Лажното аудио тврди дека поранешниот американски претседател Џо Бајден треба да учи од рускиот претседател Владимир Путин „како се работи во национален интерес“. Во оригиналното интервју, гувернерот не ги спомнува ниту Путин ниту Бајден, што беше потврдено од страна на „Фокс њуз“ (Fox News) и канцеларијата на гувернерот.

Другата страна на медалот е употребата на синтетички аудио записи за синхронизација на видеа со цел да се скрие акцентот или националноста на креаторот на видеото. Особено, оваа тактика беше користена во она што подоцна беше препознаено како најголема операција за влијание откриена на Тик-ток, во која DFRLab и BBC Verify заеднички истражуваа илјадници пропагандни видеа на седум јазици во кои се обвинува украинското раководство за корупција. Со други зборови, пропагандистите подготвувале текстови што биле изговорени од вештачка интелигенција со неутрален акцент, криејќи го потеклото на кампањата. Овие аудио снимки биле наметнати врз сет од слики кои наводно „докажуваат“ богатство на функционери, дозволувајќи им на нивните руски продуценти да избегнат непосредно откривање.

Текст

Една од најочигледните примени е преведувањето. Иако на почетокот од инвазијата, пишаните руски дезинформации во Украина често беа потсмевани поради граматички грешки, квалитетот на текстовите подоцна значително се подобри. На пример, кампањата „Допелгангер“ (Doppelganger) промовираше негативни приказни за Украина со несовршени, но убедливи преводи што изгледаа подобро од претходните напори. Според „Рекордер фјучр“ (Recorded Future), генеративна вештачка интелигенција била користена за создавање статии за веб-страници на англиски јазик поврзани со кампањата Допелгангер, како што е Electionwatch.info, што значи дека оригиналните новинарски приказни од веб-страници биле преработени од вештачка интелигенција со однапред одредено пристрасно толкување. Големите јазични модели исто така се користат за генерирање коментари. На пример, извештајот на OpenAI содржи пример за тоа како специјалистите на компанијата откриле и сопреле употреба на нивниот модел во информативна кампања за генерирање коментари за социјални мрежи.

Непосредно неповрзан со создавањето текст, но важен, е проблемот на загадување на големите јазични модели што се обучуваат врз основа на интернет-содржина. На пример, едно истражување на „Њуз гард“ (NewsGuard) покажува дека големите јазични модели може да се повикуваат на руски или проруски дезинформациски извори кога корисници поставуваат многу специфични прашања. Некои истражувачи го поврзуваат ова со пропагандната мрежа „Правда“ (Pravda), која ја загадува Википедиа, но проблемот е поширок, бидејќи јазичните модели можат да собираат информации од и да се повикуваат на руските државни медиуми, кои објавуваат стотици објави дневно, од кои дел се цитати на функционери и очигледна манипулација и дезинформации.

Автоматизација

Вештачката интелигенција не се користи само за создавање содржини, туку помага и во градење инфраструктура за ширење дезинформации преку вештачки создадени профили на социјалните мрежи. Во јули 2024 година, Министерството за правда на САД објави операција за спречување на функционирањето на мрежа од вештачки креирани профили, засилени со вештачка интелигенција, која потекнува од Руската Федерација, за ширење пропаганда и дезинформации во САД. Според документите на агенцијата, софтверот што го користеле Русите содржел компоненти на вештачка интелигенција за генерирање слики и текстови.

Оттаму, вештачката интелигенција има бројни примени во организацијата, подготовката и спроведувањето на информациски операции. Злонамерни актери ја користат ВИ за создавање профили на социјалните мрежи, преработка на содржини за нивните веб-страници, генерирање коментари и манипулација со видео и аудио материјали за да влијаат врз корисниците и да шират лажни информации, недоверба и очај. Сепак, вреди да се напомене дека вештачката интелигенција е само алатка која може да се користи не само за ширење дезинформации, туку и за нивно откривање и спротивставување. Стартапи како LetsData користат вештачка интелигенција за рано откривање на информациски закани, овозможувајќи поефективно справување со нив.

Роман Осадчук

(Преземено од Республика)